MLPerf とはAI のトップ・ベンチマークを知る

常に進化する一連の実環境での AI テストにより、インテルのエキスパートはパフォーマンスを向上させ、公平な競争環境を整え、あらゆる人が AI を容易に利用できるよう取り組んでいます。

MLPerf は、聞いたことはあるものの (まだ) 完全には理解されていないかもしれない AI ベンチマークのセットです。

この単語自体の明確な定義は見つかりませんでしたが (2018年5月の公開デビューでは「SPEC for ML」として例示されました)、私の便利な AI アシスタントは自信を持って答えを持っています。「「MLPerf」という名前は、機械学習の「ML」とパフォーマンスの「パフォーマンス」を組み合わせた造語です」と書かれています。

「命名プロセスに関する詳細な公開ストーリーはありませんが、名前自体は非常に分かりやすく、ベンチマークの目的を端的に表現するために選ばれた可能性があります。」(AI 研究者によって構築され洗練された AI に期待するような支援的な答えです。

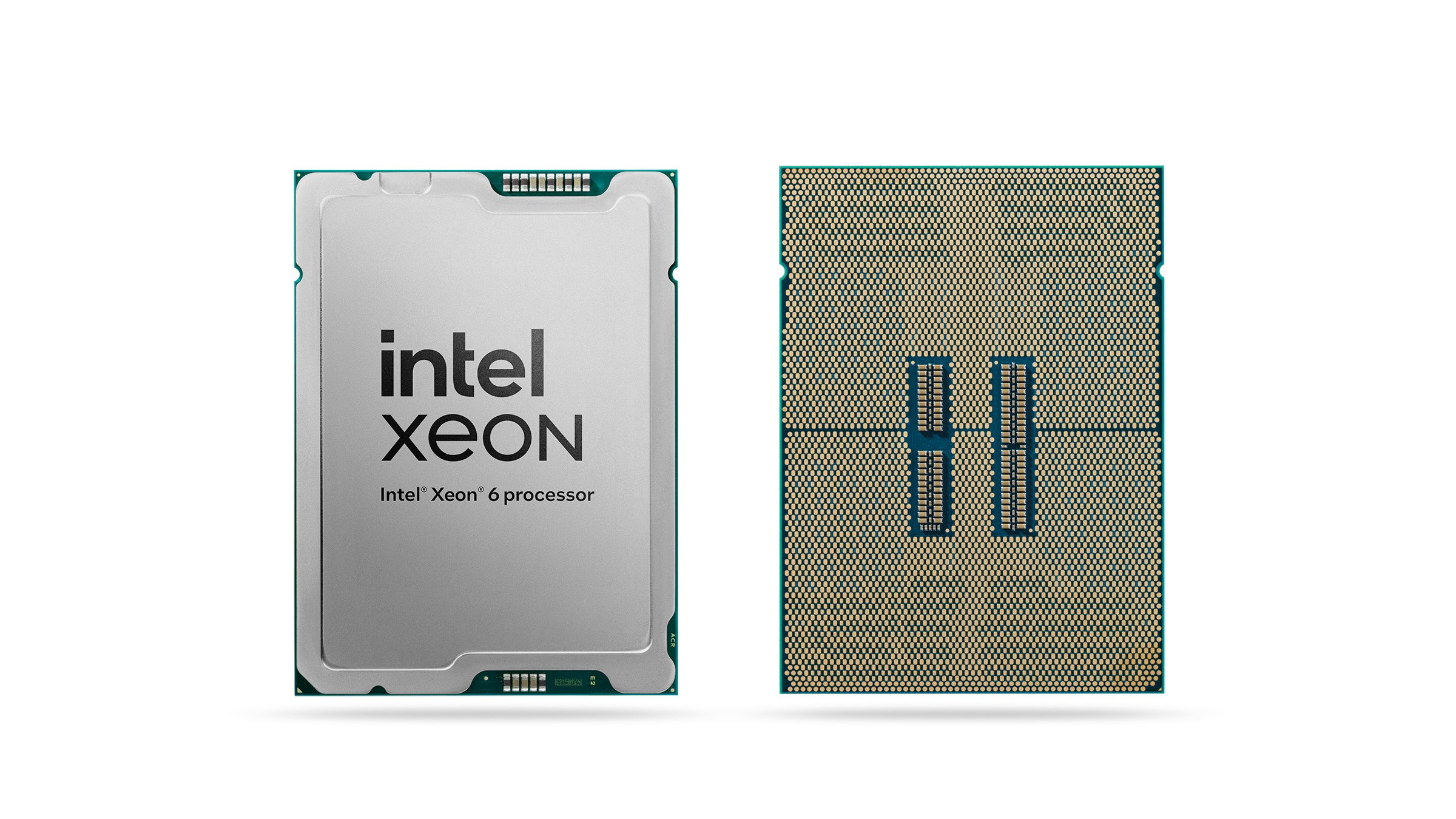

実際の結果は要点を示しています: ちょうど 先週、インテルはサーバー CPU の結果を MLPerf に提出した唯一のベンダーとしての記録を続けました。これらには、インテル® Xeon® 6 プロセッサーを使用した画像検査や情報分析などの一般的な AI タスクのパフォーマンスが含まれます。

AI プレイオフの背景にある人とプロセス

「MLPerf は現在、AI のベンチマークの第 1 位です」と、インテルのデータセンターおよび AI ソフトウェア事業部の Ramesh Chukka は述べています。

Ramesh Chukka は、インテルのデータセンターおよび AI ソフトウェア事業部の AI ソフトウェア・エンジニアリング・マネージャーであり、MLCommons コンソーシアム・ボード のメンバーです。

最新の AI と機械学習のデータセットとモデル、ベスト・プラクティス、ベンチマーク、指標の開発とアクセスを促進する」ための MLPerf の取り組みを拡大するために2020年後半に設立されたコンソーシアムである MLCommons の取締役会でインテルを代表 しています。

MLPerfは、それ自体がすべてのベンチマークを指し、「テクノロジーの進化と同様に非常に速いペースで進化しています」と Chukka は述べ、「新しい AI 技術のラピッド・プロトタイピング」でこの分野を前進させるという使命を果たしています。各ベンチマークは、一定レベルの品質が与えられた特定の AI ジョブがどれだけ速く完了できるかを測定します。

ベンチマークは、2 つの主要なカテゴリに分けられます。一つはデータを使用して AI モデルを構築する学習、もう一つは AI モデルをアプリケーションとして実行する推論。大規模言語モデル (LLM) を例に説明すると、学習とは LLM が情報のコーパスから学習するプロセスであり、推論はあなたが何か指示した都度、発生します。

MLCommons は、2 つのカテゴリーそれぞれについて、年に 2 セットのベンチマーク結果を公開しています。例えば、直近ではインテルが昨年 6 月に学習結果を共有し、今月推論結果を共有しています。

インテル AI エキスパートは、 MLPerf (ひいては MLCommons) の初日から貢献しています 。インテルの参加は常に 2 つあります。取り組み全体の形成と進化を支援すると同時に、インテル® プロセッサー、アクセラレーター、ソリューションを使用してベンチマーク結果をコンパイルして貢献することです。

MLPerf ベンチマークが解決する問題点

AI モデルは複雑なプログラムであり、多種多様なコンピューターで実行できます。MLPerf ベンチマークは、これらのコンピューターをより適切に比較できると同時に、研究者や企業に最先端技術を促進するように設計されています。

各ベンチマークは、可能な限り実環境を反映することを目的としており、結果は 2 つの部門のいずれかに分類されます。AI モデルとソフトウェア・スタックの「クローズド」ディビジョン・コントロールにより、可能な限り最良のハードウェアとハードウェアの比較が可能になります。つまり、それぞれの異なるシステムは、同じアプリケーションを使用して同じ結果 (たとえば、自然言語処理の精度尺度) を達成します。

「オープン」部門はイノベーションを可能にします—各システムは同じ望ましい結果を達成しますが、可能な限りパフォーマンスの限界を押し上げることができます。

MLPerf の素晴らしい点は、すべてが共有され、ベンチマークがオープンソースであることです。結果は再現可能である必要があり、謎は残りません。このオープン性により、電力当たりの性能やコストなど、生の速度を並べて並べただけでなく、より動的な比較が可能になります。

MLPerf の仕組みと進化

Chukka が述べたように、MLPerf は継続的に進化し、新しいベンチマークを追加することで、その卓越性を部分的に維持しています。そのプロセスがどのように行われるかは、主に大企業、新興企業、学界にまたがる MLCommons コミュニティ間のオープンな議論と議論を通じて行われます。

新しいベンチマークが提案され、議論され、承認されたベンチマークには学習用のオープンデータセットが必要ですが、これが存在する場合と存在しない場合があります。コントリビューターは、チームを組んでベンチマークを構築し、データを識別または収集し、ベンチマークのリリースのタイムラインを設定することを志願します。

結果を公開したい企業は、次のリリースの期限を守る必要があります。彼らがそれを逃した場合、彼らは次のラウンドを待ちます。

より速く、より効率的な AI から世界が得るもの

世界中のより多くの人々が半導体を使用してより多くの問題を解決できることは、インテルにとって明らかな全体像のメリットをもたらしますが (販売およびマーケティング部門にとってのメリットは言うまでもありません)、MLPerf へのインテルの参加には他にもメリットがあります。

インテルは、PyTorch や AI の拡張機能など、AI 向けのオープンソース・フレームワークに常に貢献してきました 。インテルのエンジニアが MLPerf の結果を高速化する作業を通じてコードを改善していくと、ダウンストリームインテル のチップ上で同様の AI を実行しているすべての人が、手間をかけずにそれらの改善を得ることができます。

「新しいベンチマークについては、常に実行できる最適化を検討しています。そして、次のいくつかの提出物を探し続けています」と Chukka は言います。

Chukka のチームは、インテル全社から協力者を招集し、結果の構築改良を行っています。時には各ラウンドで劇的な改善を達成することもあります (例えば、2024年のレコメンダー推論の結果が 80% 向上し、今月の GPT-J ベンチマークが 22% 向上)。

したがって、インテルが MLPerf の結果の新しいラウンドを公開したと聞くたびに、あらゆる種類の AI システムがより速く、より効率的になったことを喜ぶことができます。たぶんあなたのお気に入りの LLM でさえ、新しいプロンプトごとにより速く、より巧妙な答えを提供します。

Jeremy Schultz は、インテルのグローバル・コミュニケーションおよびイベント・チームのライター兼エディターです。

パフォーマンスは、使用状況、構成、その他の要因によって異なります。詳細については、www.Intel.com/PerformanceIndex を参照してください。

性能の測定結果は、構成に示されている日付時点のテストに基づいています。また、現在公開中のすべてのアップデートが適用されているとは限りません。 詳細については、MLCommons をご覧ください 。 絶対的なセキュリティーを提供できる製品またはコンポーネントはありません。